שנת 2024 מתקרבת לסיומה וכפי שכולנו יודעים היא הייתה מאתגרת וקשוחה מאוד, אבל הפעם אני מתייחס להיבט של הסייבר, בדגש על AI.

כולנו מתלהבים מהיכולות המדהימות של ChatGPT וארגונים רבים כבר מטמיעים בתהליך הפיתוח רכיבי AI. הסיבות לכך הן רבות, כגון: יעילות, ממשק חכם מול הלקוח ועוד.

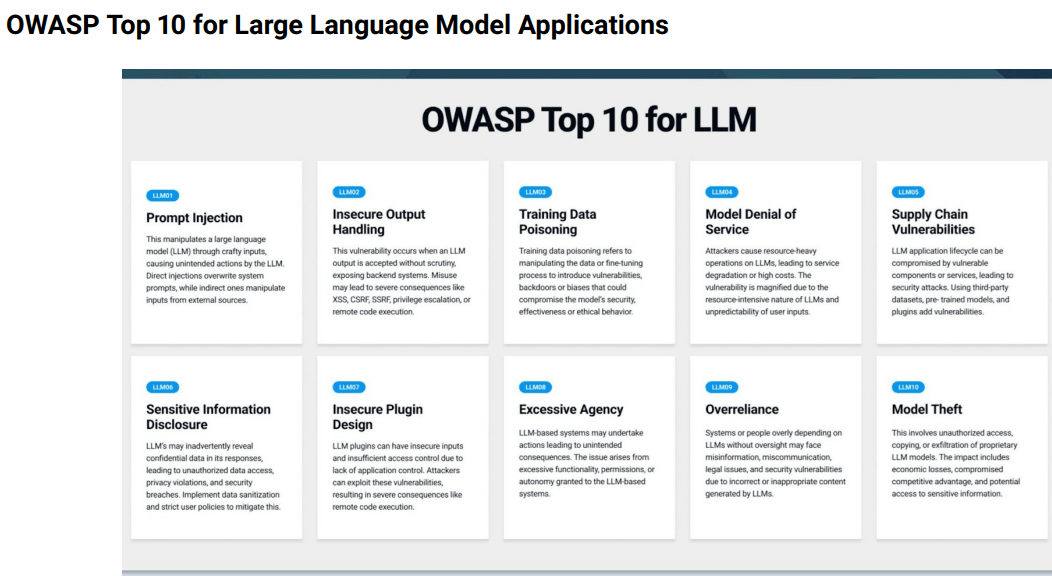

אבל, כפי שלמדנו בחיים, טכנולוגיות חדשות משמשות גם את הצד התוקף. לדוגמה, אחד הפרסומים המעניינים כיום הוא שילוב של OWASP Top 10 for LLM במהלך בדיקות חדירות. כן, תתפלאו, אבל הגבינה שוב זזה וזאת מהסיבה ששילוב AI מגדיל את משטח התקיפה של הארגון.

תוכן עניינים

Toggleהסיכונים בשילוב AI במערכות

LLM (Large Language Model) כזכור הוא סוג של AI שיכול לחקות אינטליגנציה אנושית, ובשביל שיוכל לבצע זאת היטב על צוותי הפיתוח לספק לו כמויות אדירות של מידע. רק אז, בעזרת מודלים סטטיסטיים הוא ינתח את הנתונים וילמד את הדפוסים והקשרים בין מילים וביטויים.

יכולת השימוש ב-GenAI (Generative AI, למידת מכונה שמתמקדת ביצירת נתונים חדשים) מאפשרת לתוקפים לשכלל באופן מדהים את יכולות התקיפה. GenAI אמור להגיב למשתמשים בשפה טבעית, לכן, מטבע הדברים, חלק מהתקיפות יתבססו על ניסיונות הוספת נתונים מגמתיים על מנת להשפיע על תוצאות החיזוי של המודל. בעצם, מה שנקרא בעבר SQL Injection שכוון למסד הנתונים, הופך למתקפת Prompt Injection על LLM.

היערכות מוקדמת וצמצום הסיכונים

אחת הנקודות הלא מפתיעות היא ההיערכות מראש שעל צוות הפיתוח לקחת בחשבון. לדוגמה, האם ניתן לאבטח את הגישה למערכות מהן המודל לומד? האם מקשים על התוקף בעזרת שימוש במסננים שינסו למנוע סוג של הנחיות זדוניות? כמו כן, יש לבחון היטב עד כמה שימוש זדוני במודל חושף את הארגון לסכנות משפטיות בגלל זליגת מידע פרטי.

OWASP ממליצים על ביצוע מבדקי PT (Penetration Testing) ו-AI Red Team כדי לבדוק האם תוקף יכול להגיע למערכות הפנימיות וכן להשפיע על אופן הלימוד של המודל.

OWASP Top 10 for LLMs

הנושאים שנבחרו הם:

- Prompt Injection

- Insecure Output Handling

- Training Data Poisoning

- Model Denial of Service

- Supply Chain Vulnerabilities

- Sensitive Information Disclosure

- Insecure Plugin Design

- Excessive Agency

- Overreliance

- Model Theft

אצלנו ב-Madsec נצבר ניסיון רב בנושא ונשמח לעמוד לשירותכם.